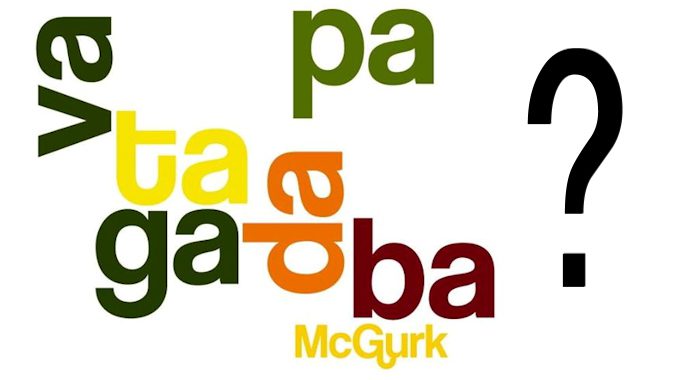

Mai sentito parlare dell’effetto McGurk? Si tratta di una delle tante dimostrazioni di come la nostra percezione del mondo dipenda spesso dalla fusione di più sensi. L’articolo firmato proprio dallo psicologo cognitivo inglese e dal titolo “Hearing Lips and Seeing Voices” (“Ascoltare le labbra e vedere le voci”), pubblicato nel lontano 1976, è emblematico di quanto la contaminazione sensoriale giochi un ruolo determinante nella nostra vita. Lo studio di McGurk voleva dimostrare in sostanza come l’integrazione degli input acustici e di quelli visivi porti al riconoscimento del parlato. Qualora però si verifichi un conflitto tra i due, poiché il nostro cervello mal tollera le ambiguità, il canale visivo risulta privilegiato o si fonde con quello uditivo per generare una percezione illusoria, il cosiddetto effetto McGurk. Per capirci qualcosa di più è preferibile vedere qualche esempio: con questo video vi sarà tutto più chiaro.

A distanza di quasi 40 anni, una nuova ricerca dell’Università dello Utah a Salt Lake City, comparsa su Plos One, dimostra le modalità di prevaricazione della vista sull’udito nella manifestazione di quest’effetto. A quattro pazienti affetti da una grave forma di epilessia intrattabile farmacologicamente, sono stati impiantati degli elettrodi in vista di un’operazione. Gli scienziati hanno potuto così osservare cosa succede nella corteccia temporale nel momento in cui vengono elaborati i suoni. Lo studio ha comportato la somministazione di un video sonoro raffigurante una bocca pronunciante una di quattro possibili sillabe; in alcune scene però, i movimenti della bocca non corrispondevano a quelli propri della sillaba associata.

Quando il filmato mostrava il labiale corrispondente alla sillaba proposta dal sonoro o quando una sillaba era molto diversa da quella emessa dall’altoparlante, le persone la identificavano perfettamente. Quando invece audio ed immagini erano solo leggermente differenti, come per esempio nelle sillabe “va” e “ba”, i soggetti identificavano come pronunciata la sillaba che in realtà non era stata udita ma soltanto vista.

Nello specifico, i ricercatori hanno potuto rilevare che le informazioni visive che vengono elaborate nella corteccia occipitale sono inviate da questa verso l’area uditiva primaria, dimostrando che la rappresentazione neurale del suono udito viene influenzata dagli stimoli visivi fin dal primo momento. Questo monitoraggio apre una finestra importante sulla dislessia, relativamente ai problemi di integrazione fra stimoli visivi e uditivi, e nel contempo anche sui meccanismi che nei bambini piccoli consentono di associare i suoni al movimento delle labbra.